Немного о чатах GPT и Deepseek

Не очень характерный для меня пост получился. И очень длинный. Его есть смысл читать, если вам интересно, как работают GPT и Deepseek, почему они ошибаются. И как это исправить. Будет много ссылок на Habr (отобрала тексты, которые может понять обычный человек). И немного моих размышлений.

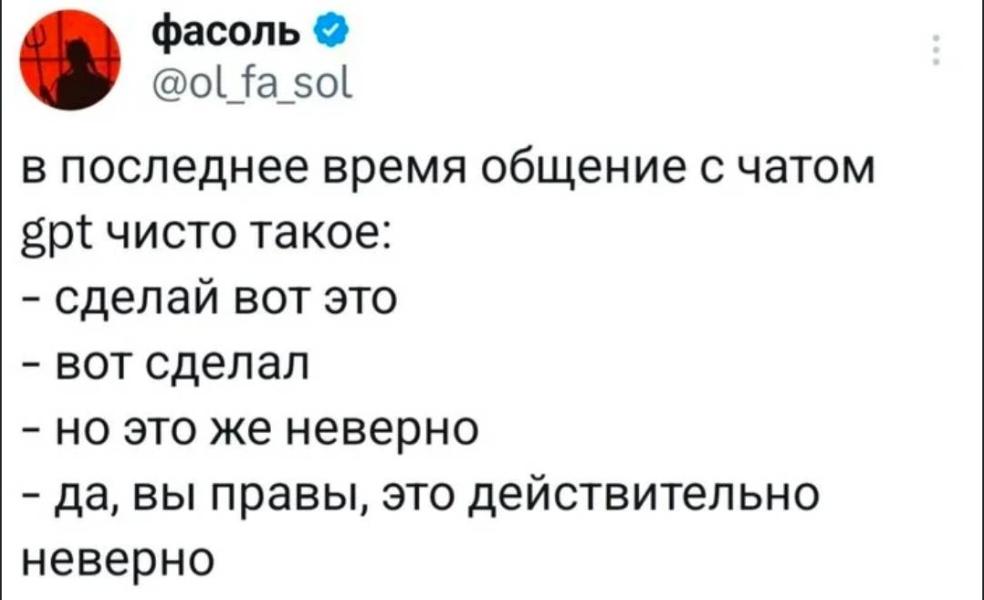

В последнее время в приложении все больше постов, что с помощью чатов gpt и deepseek можно узнать любую информацию. И по лечению советы дают, и по бизнесу, и вместо психологов расклады делают. И даже кому-то планы на день составляли.

С одной стороны, это достаточно мощные инструменты, которые обучены на огромном количестве данных. И какой-то ответ они могут дать по любому вопросу.

Если кому-то интересно, как работают эти чаты, почему они вообще могут отвечать на вопросы, рекомендую очень крутую статью, которая на пальцах разбирает этот феномен:

ссылка

и вторая часть ссылка

С другой стороны, вероятность получить ответ с ошибкой достаточно велика.

Периодически, энтузиасты проводят исследования, по оценке точности ответов в том же gpt. Проверяют на точных данных, где правильных решений ограниченное количество, и где решение можно однозначно проверить. Например, вопросы по математике, программированию и т.д.

Оцениваются обычно, какое количество ответов было сделано с ошибкой, по сравнению к общему количеству ответов.

И точность gpt чата за последние 1,5 года варьировалась от 40 до 88%. То есть, в худшем случаи, в каждом 2 ответе, а в лучшем случаи, в каждом 6 ответе была ошибка. При этом, платные версии ошибались не меньше, чем бесплатные.

С одной стороны, люди тоже ошибаются, и люди могут ошибаться даже чаще чатов gpt. С другой стороны, к чатам стали обращаться, как к экспертам по достаточно важным вопросам. А особенность взаимодействия с чатом такая, что если вы не эксперт в области вопроса, вы не поймете в чем ошибка в ответе. Ответы у чатов всегда структурированы и вроде бы логичны. И ошибкой может быть как сама логика ответа, так и отдельные подпункты.

Тут простые для понимания примеры:

ссылка

Не самый простой для понимания стиль изложения:

ссылка

Еще немного информации тут:

ссылка

Интересная статья про ИИ применительно к юриспруденции

ссылка

Пример ошибок на детских задачах

ссылка

Для того, чтобы понять, почему вообще у чатов бывают ошибки, стоит понять, как они работают. Сразу скажу, я не эксперт в области ИИ. Было прослушано пару интересных курсов и пара попыток построить примитивную нейронную сеть. Но базовые знания получить удалось.

Первый важный момент. Откуда у чатов gpt и deepseek вообще берется информация и как она обрабатывается.

Начнем с того, что нейронные сети не могут напрямую работать ни с текстом, ни с изображениями. Их язык - это язык цифр. И чтобы обработать картинку или текст, их вначале нужно перевести на язык цифр.

Картинки, например, можно поделить на небольшие фрагменты, например 20 на 20 пикселей (число условное, для примера), где 1 пиксель - это одна точка. У каждой точки есть конкретный цвет. Этот цвет можно записать в формате RGB (green-blue-red). Например красный в таком формате выглядел бы (255, 0, 0). И данные картинки попиксельно переводятся в цифровой формат. А дальше происходит магия. набор этих чисел преобразовывают в вектор. Векторы мы рисовали в школе Это были стрелочки с начальной и конечной точкой координат. Здесь векторы сильно больше. И по-сути это набор цифр [0.25, 0.36, 0.78, … , 0.1].

Тексты тоже переводятся в цифры. Только нам важны не только слова, но и их последовательность. Поэтому в векторы переводятся последовательности слов. Например, в первый вектор переводится 1, 2, 3, 4, 5 слово текста, во второй вектор 2, 3, 4, 5, 6 слово и так далее. Бывают более сложные способы, учитывающие части слова. Но тоже последовательности переводятся в цифры.

Вот тут нагляднее рассказано про обработку текста:

ссылка

И дальше идет построение нейронных сетей. Более или менее простое объяснение в этой статье ссылка

Вот тут немного сложнее, но гораздо подробнее

ссылка

Если коротко, то модель ищет признаки и определяет их важность.

Например, мы хотим обучить модель работать с картинками (определять, корректировать, потом и генерировать). Но в начале мы должны обучить модели, какому слову какое изображение соответствует. А то как иначе модель поймет, что кошка - это кошка?

Мы даем 1000000 картинок, где присутствует кошка, и, допустим, еще 1000000 картинок, где есть собака. Нейронная сеть вначале знает, на каких картинках есть кошки, а на каких картинках есть собаки. Она выделяет признаки (для этого она ищет, какие кучки пикселей схожи по векторам, точнее по цветам (вектора у нас как раз и показывают цвета)) и по этим признакам пробует предсказывать на картинке кошку или собаку.

Например, если большая, кудрявая и с высунутым языком - это собака. А если маленькая, пушистая и спит - то кошка. При этом какие-то признаки могут больше соответствовать собаке (например большой рост), а какие-то могут быть и у кошки, и у собаки (например цвет). Уникальные признаки получают больший вес (больший коэффициент), а не уникальные - меньший вес (коэффициент).

После того, как выделили признаки (рост, цвет, форма носа и т.д.) и их веса, в нейронную сеть добавляют не подписанные картинки кошек и собак. И модель пробует предсказать, на картинке кто находится. Если много ошибок - отправляем модель переобучаться. Это обучение с учителем.

Есть обучение без учителя. Например, засунули в модель 1000000000 текстов. И модель начала искать закономерности. Какие слова чаще всего встречаются друг с другом. И поиск этот ведется через схожесть векторов (мы же все последовательности слов перевели в цифры).

А дальше примерно логика работает так. Например, нам нужна столица Никарагуа. и так получилось, что в загруженных для обучения данных, этой информации не было.

Дальше сети нужно понять, что такое столица. Она находит в других текстах (о других странах), рядом со словом столица есть слова “крупнейший город”, “правительство”, “деловой центр”, “государственные символы” и т.д. Дальше она ищет, где рядом со словом Никарагуа есть похожие слова. И рядом с каким городом они чаще встречаются - тот и столица.

У этого метода есть как плюсы, так и минусы. с одной стороны, когда вам нужно мнение психолога, то понятно, что такого текста в интернете нет. И при генерации ответа чат подбирает последовательность слов на основе других миллионов консультаций. И тем самым может давать такие ответы на вопросы, которых сейчас нет в интернете. С другой стороны, именно здесь могут и появляются ошибки.

Пара слов, как осуществляется генерация текста. Вот GPT определился в понятиями и готов нам ответить на вопрос.

Важно. Текущий чат GPT - это очень продвинутая обученная Т9.

Он слово за словом пишет с учетом вероятности его появления в тексте. То есть он берет уже написанную им часть текста, и дальше определяет, какое наиболее вероятное слово сейчас может быть (вспоминаем, что обучение было на последовательностях слов). Методика немного сложнее, так есть еще коэффициент неопределенности. Но по сути, это все та же Т9, только очень продвинутая.

Начало статьи хорошо объясняет работу генерации текста

ссылка

Большая часть статьи написана очень сложным языком. Но начало понять может любой человек.

Вот тут подробнее. Но язык статьи может показаться сложным

ссылка

Итоговая мысль:

На входе был какая-то большой объект (тексты, например). Чат разобрал его на маленькие кусочки, запомнил основные последовательности, а потом из кусочков попробовал сделать что-то соответствующее запросу.

Откуда же берутся ошибки в генерации ответов.

Нужных данных не было в изначальном наборе данных. и чат пробует подобрать ответ. И здесь могут быть ошибки (например, условно Нью-йорк может получить большую вероятность быть столицей, чем Вашингтон, или чат может найти несуществующую столицу у Щвейцарии). Примеры привожу для понимания, они условны. Кстати, юристы часто жалуются, что тот же gpt чат часто придумывает несуществующие законы.

Изначальные данные могут быть с ошибками. Например, в трудовом законодательстве статей с недостоверными данными не меньше, чем статей с достоверными данными. И солянка из этих данных может дать гремучую смесь. И если в гугле понятно, что консультанту доверять можно, а условному сайту развлечений нет, то тут источники не известны и непонятно, на сколько можно доверять информации в принципе.

Данные могли устареть. Например, недавно в одном посте-вопросе по трудовому праву одна из девушка дала ответ из deepseek с сильно устаревшей информацией, которая противоречит текущему законодательству.

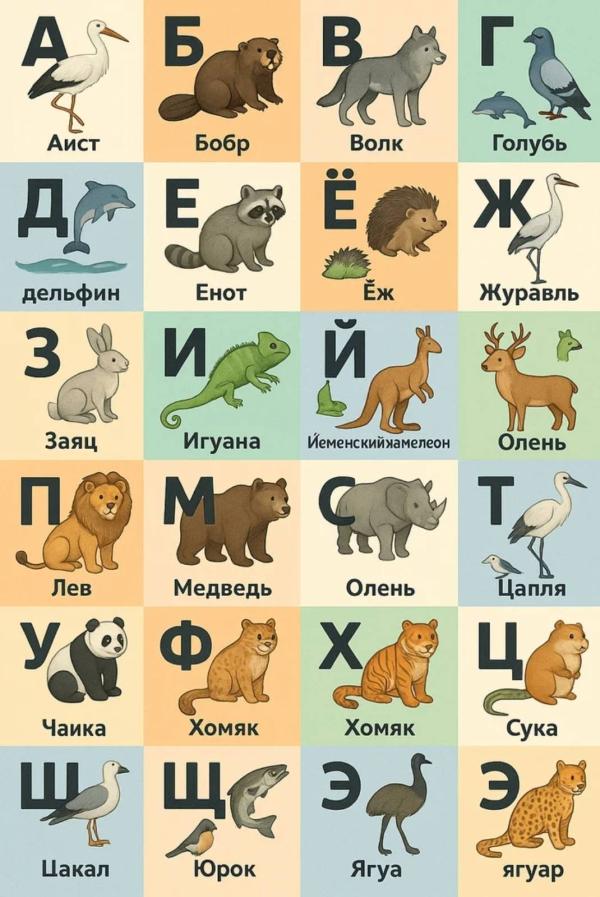

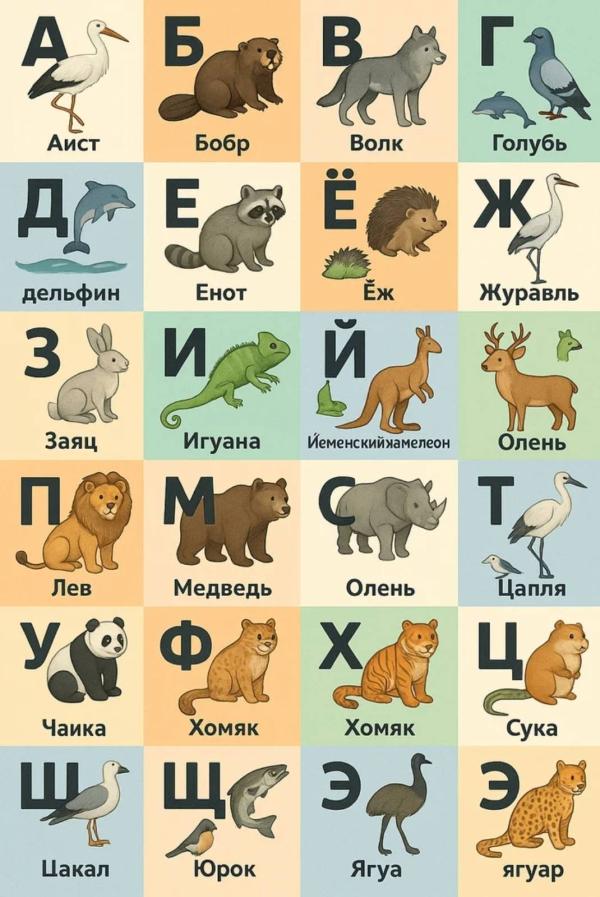

Бывают галлюцинации у чатов. Примеры некоторых галюцинаций я привела в изображениях. Например, сложность мог вызвать вопрос о перевернутой кружке, проблемы с днями недели и т.д. Неплохая статья про причины галюцинаций ссылка

Неправильное понимание контекста ситуации. Например фразы: Котенок съел пирожок, он был вкусный. Котенок съел пирожок, он был голодный. содержат разный контекст, который скорее всего будет не понят.

Предвзятость самой модели в политических, социальных, исторических вопросов. Примеры есть в статье ссылка

Ошибки в рассуждении модели, которые могут приводить к ошибочным выводам.

Что делать?

gpt и deepseek - это неплохие инструменты, если понимать их ограничения. Общий поиск информации, мозговой штурм, общее изучение проблемы, возможные варианты решения, поиск ошибок в коде. Есть много способов их применения.

Только если информация важная, имеющая серьезное влияние (например здоровье, юридические вопросы и т.д.), то ответы от чатов стоит перепроверить. Даже если они кажутся очень логичными.

Плюс изучение промтов (запросов), может помочь писать запрос так, что бы снижать риски появления ошибок.

Ссылки в помощь.

Ссылка раз: ссылка

Ссылка два. Достаточно подробно расписано: ссылка

Ну и последнее. Одно из конкурентных преимуществ нашего поколения (рожденных в 80-90 года), это адаптация, обучаемость, гибкость. Готовность к переменам. (это мое видение, не претендую на истинность)

Постоянное решение вопрос через тот же gpt приводит к началу атрофии умений поиска и обработки информации, принятия решений. Помощники - это хорошо. Но не стоит важные вопросы перекладывать на них.

И еще один момент. Когда ошибка делается в тексте, особенно если это большое рассуждение, не всегда эту ошибку можно оперативно заметить.

Гораздо нагляднее ответы на запросы в визуализациях. Там видны и отсутствие информации, и устойчивые шаблоны, и галлюцинации. Но это тема отдельного поста.

#для_подписчиков

Комментарии

Учусь на аналитика данных по содействию занятости и стыдно признаться,но если бы не DeepSeek,то я бы ни одно домашнее задание им бы не сделала .

@ks_111 на kaggle можно взять датасет для работе. Но там специфика. Анализируют либо с помощью машинного обучения, либо нейронными сетями. Датасеты большие, могут быть несколько миллионов строк. Зарегистрироваться посмотреть можно, но для старта я бы проще что-нибудь взяла.

Например датасет по стоимости жилья.

@iv.tishkina, а подскажите где вы их берете,кроме как kaggle?

@ks_111 я сейчас больше на работе нахожу. Раньше в и-нете находила. Есть много готовых датасетов.

Как пример, у нас с несколькими девушками mom life был проект - спарсили данные с hh, а потом я показала, как эти данные обработать. А так, есть много данных и от гос органов со статистикой.

Вокруг все пользуются чатами) но когда мне дипсик сказал то на Мальдивах с одного острова можно добраться до другого на велосипеде или велорикше 😂😂😂я поняла что ему нельзя доверять. Нам людям взрослым с критическим мышлением с большим опытом и знаниями легко понять где ошибка ( ну хотя бы мы подвергаем сомнению то что пишет чат) а вот детям😢им очень тяжело. Они принимают инф за чистую монету. В ошибок очень много

Я тоже интересные перлы от чатов встречала. Поэтому для меня странно, когда юридические, медицинские или экономические вопросы спрашивают у чатов, как у экспертов.

@iv.tishkina, да спросит можно. Но!!! Критическое мышление тут очень нужно и важно. А вот дети им не обладают ((( меня прям очень беспокоит что дочь например интернету верить порой больше чем мне 😭

Очень интересно написано, сохранила, чтобы перейти по ссылкам попозже

Спасибо

Очень интересно!

В любом случае это инструмент, которым надо уметь пользоваться))

Спасибо, безумно интересно! Как раз искала информацию)

Спасибо большое за информацию 🌸